Service 的概念

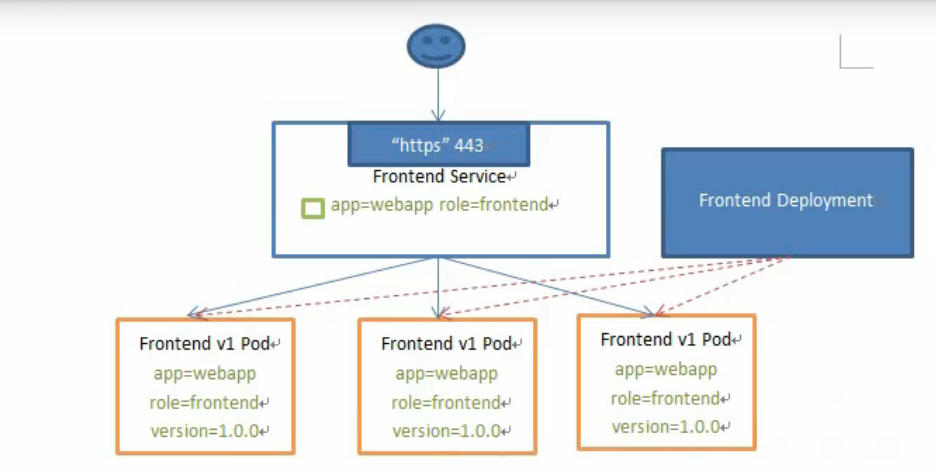

Kubernetes service 定义了这样一种抽象:一个 Pod 的逻辑分组,一种可以访问它们的策略 – 通常称为微服务。这一组 Pod 能够被Service访问到,通常是通过Lable Selector

Service能够提供负载均衡的能力,但是在使用上有以下限制:

- 只提供4层负载均衡能力,而没有7层功能,但有时我们可能需要更多的匹配规则来转发请求,这点上4层负载均衡是不支持的

Service 的类型

Service 在 K8s中有以下四种类型

- ClusterIp: 默认类型,自动分配一个仅Cluster内部可以访问的虚拟IP

- NodePort: 在 ClusterIP基础上为Service 在每台机器上绑定一个端口,这样就可以通过

: - LoadBalancer:在NodePort的基础上,借助cloud provider创建一个外部负载均衡器,并将请求转发到

:NodePort - ExternalName: 把集群外部的服务引入到集群内部来,在集群内部直接使用。没有任何类型代理被创建,这只有kubernetes1.7或更高版本的kube-dns才支持

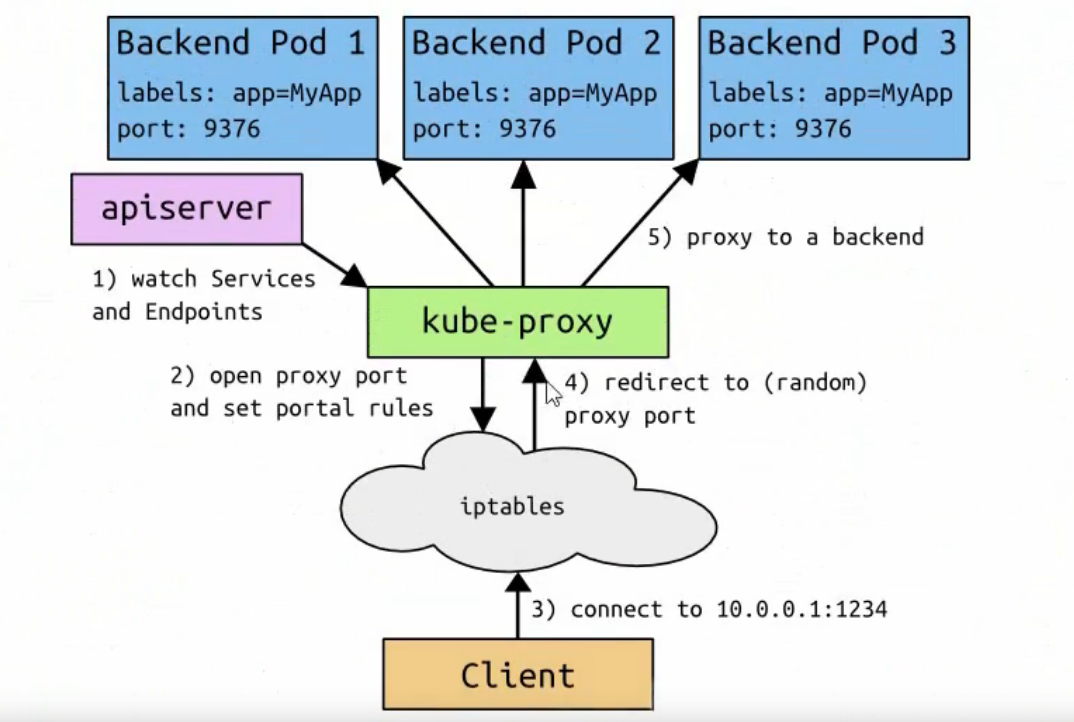

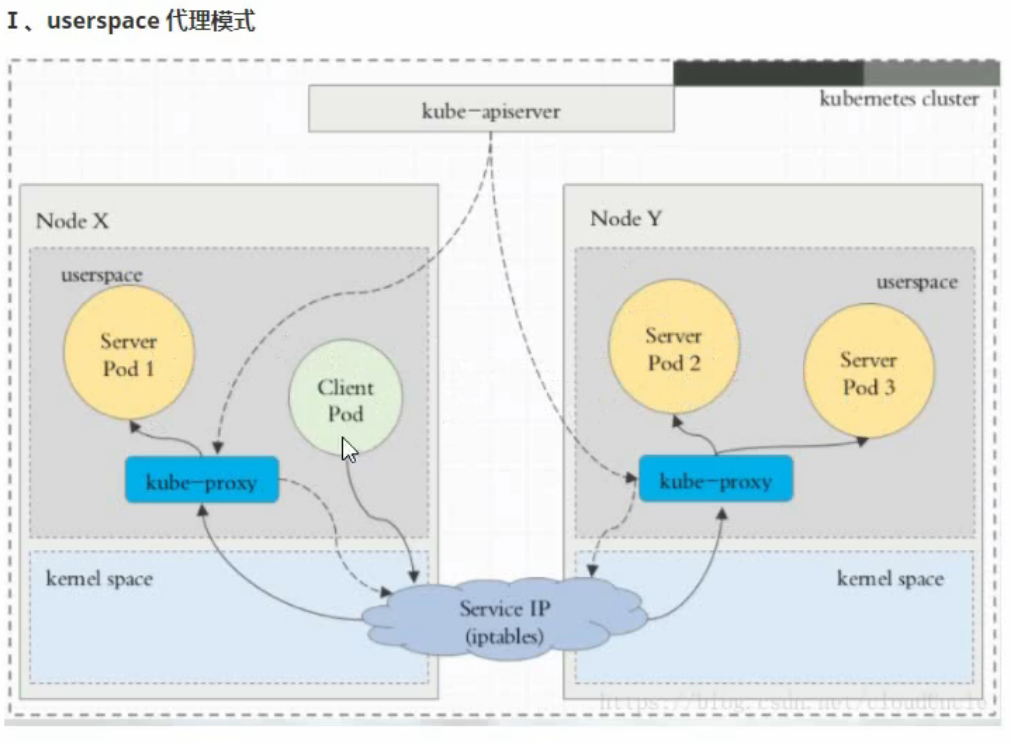

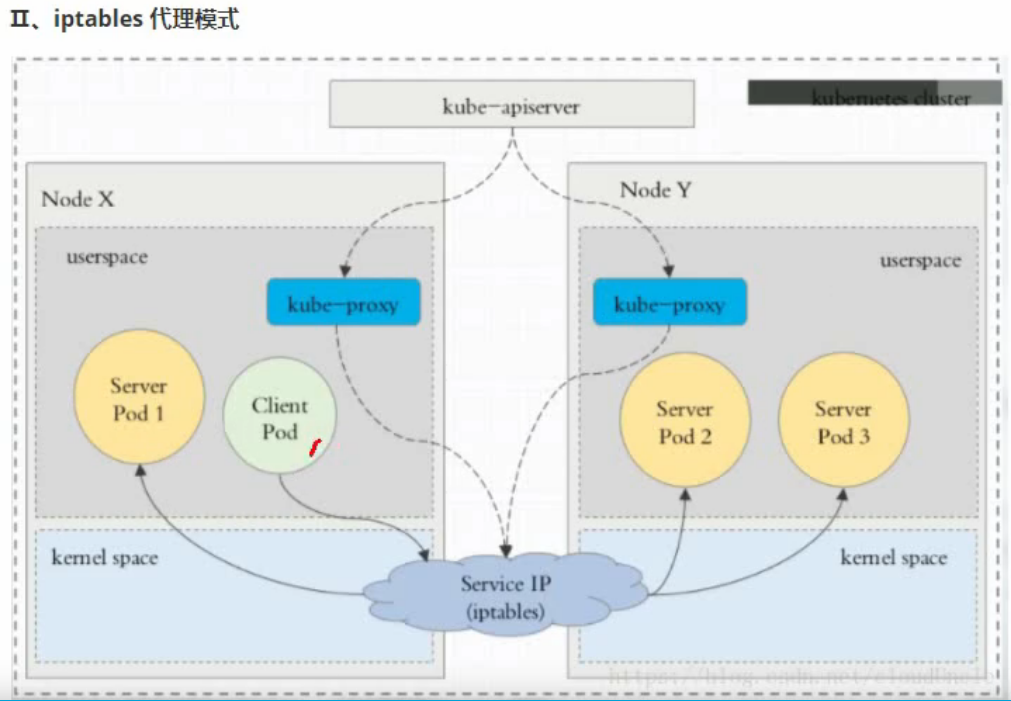

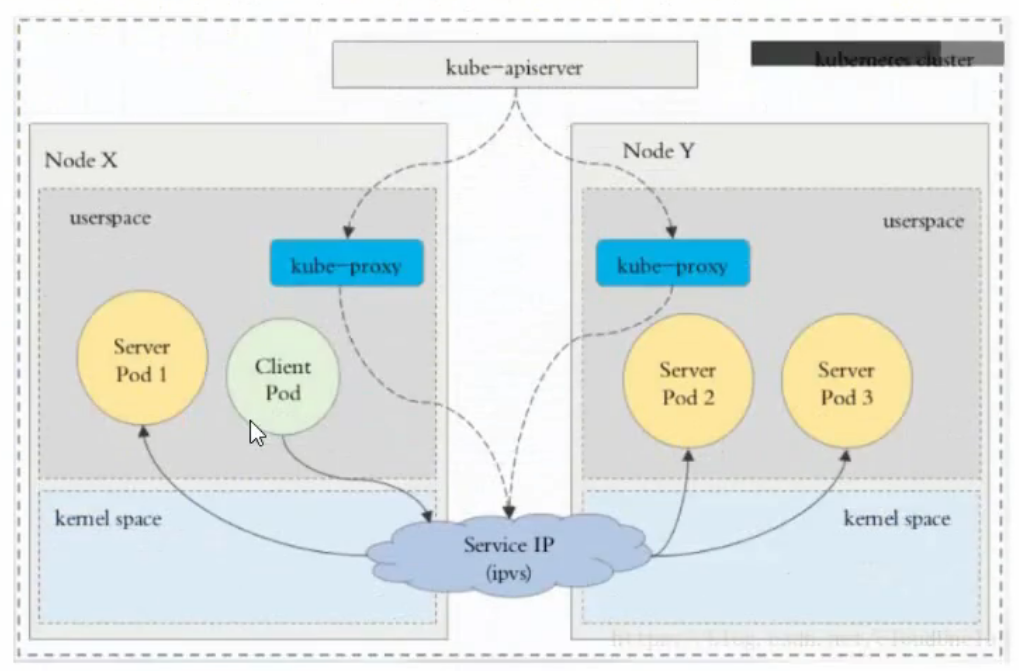

VIP 和 Service 代理

在 Kubernetes 集群中,每个 Node 运行一个 kube-proxy进程。kube-proxy 负责为 Service实现了一种VIP(虚拟IP)的形式,而不是 ExternalName的形式。在 Kubernetes v1.0 版本,代理完全在userspace。在Kubernetes v1.1版本,新增了 iptables 代理,但并不是默认的运行模式。从Kubernetes v1.2起,默认就是iptables代理。在Kubernetes v1.8.0-beta.0中,添加了ipvs代理

在kubernetes 1.14版本中开始默认使用 ipvs 代理

在 kubernetes v1.0 版本, Service是”4层”(TCP/UDP over IP)概念。在kubernetes v1.11版本,新增了 Ingress API(beta版),用来表示“7层”(HTTP)服务

!为何不使用 round-robin DNS?(DNS缓存问题)

代理模式的分类

III、ipvs 代理模式

这种模式,kube-proxy会监视kubernetes Service对象和Endpoints,调用netlink接口以响应地创建 ipvs 规则并定期与Kubernetes Service对象和Endpoints对象同步ipvs规则,以确保ipvs状态与期望一致。访问服务时,流量将被重定向到其中一个后端Pod

与iptables类似,ipvs于netfilter的hook功能,但使用哈希表作为底层数据结构并在内核空间中工作。这意味着ipvs可以更快地重定向流量,并且在同步代理规则时具有更好的性能。此外,ipvs为负载均衡算法提供了更好选项,例如:

rr: 轮询调度lc: 最小连接数dh: 目标哈希sh:源哈希sed: 最短期望延迟nq: 不排队调度

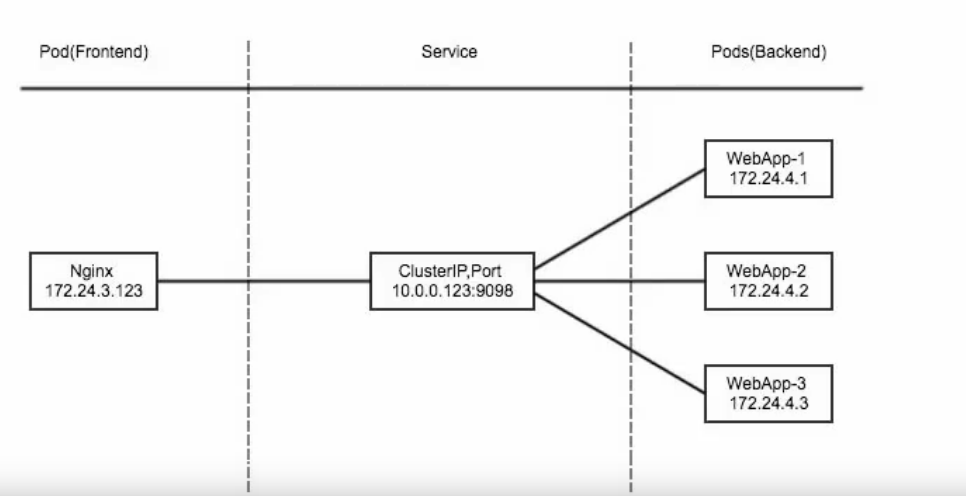

ClusterIP

clusterIP 主要在每个node节点使用iptables,将发向clusterIP对应端口的数据,转发到kube-proxy中。然后kube-proxy自己内部实现有负载均衡的方法,并可以查询到这个service下对应的pod的地址和端口,进而把数据转发给对应的pod的地址和端口

为了实现图上的功能,主要需要以下几个组件协同工作:

- apiserver用户通过kubectl命令向apiserver发送创建service的命令,apiserver接收到请求后将数据存储到etcd中

- kube-proxy kubernetes的每个节点中都有一个叫做kube-proxy的进程,这个进程负责感知service,pod的变化,并将变化的信息写入本地的iptables规则中

- iptables 使用NAT等技术将virtualIP的流量转至endpoint中

创建 myapp-deploy.yaml 文件

[root@k8s-master root] vim myapp-deploy.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: myapp-deploy

namespace: default

spec:

replicas: 3

selector:

matchLabels:

app: myapp

release: stabel

template:

metadata:

labels:

app: myapp

release: stabel

env: test

spec:

containers:

- name: myapp

image: harbor.bwingame8.com/library/myapp:v2

imagePullPolicy: ifNotPresent

ports:

- name: http

containerPort: 80创建 Service 信息

[root@master root]vim myapp-service.yaml

apiVersion: v1

kind: Service

metadata:

name: myapp

namespace: default

spec:

type: ClusterIP

selector:

app: myapp

release: stabel

ports:

- name: http

port: 80

targetPort: 80Headless Service

有时不需要或不想要负载均衡,以及单独的Service IP。遇到这种情况,可以通过指定ClusterIP(spec.clusterIP)的值为“None”来创建Headless Service。这类 Service并不会分配ClusterIP,kube-proxy不会处理他们,而且平台也不会为它们进行负载均衡和路由。

[root@k8s-master root]# vim myapp-svc-headless.yaml

apiVersion: v1

kind: Service

metadata:

name: myapp-headless

namespace: default

spec:

selector:

app: myapp

clusterIP: "None"

ports:

- port: 80

targetPort: 80

[root@k8s-master root]# dig -t A myapp-headless.default.svc.cluster.local.

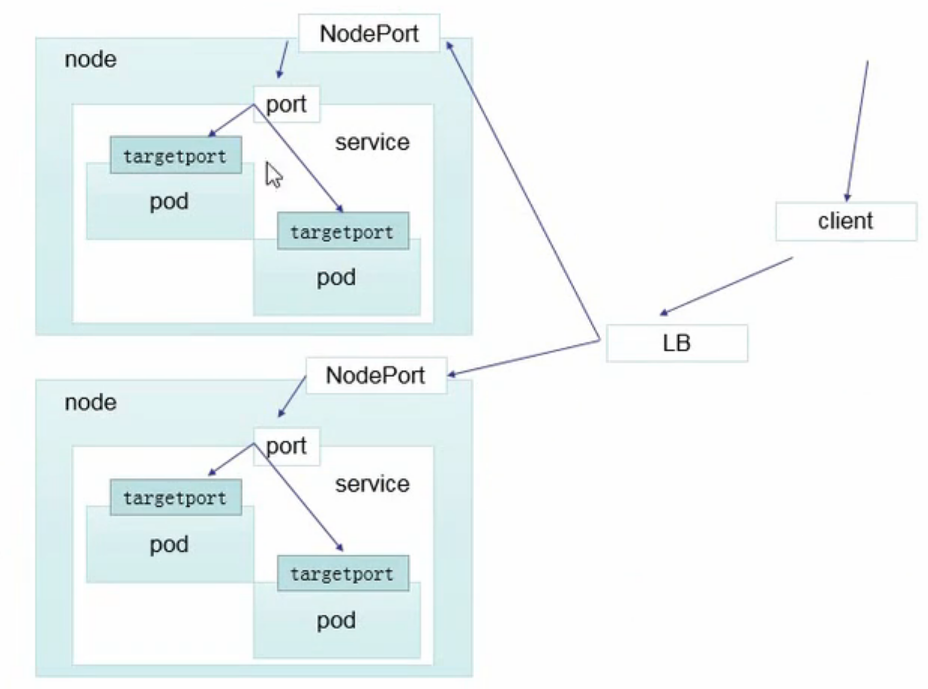

@10.96.0.10NodePort

nodePort 的原理在于在node上开了一个端口,将向该端口的流量导入到kube-proxy,然后由kube-proxy进一步到给对应的Pod

apiVersion: v1

kind: Service

metadata:

name: myapp

namespace: default

spec:

type: NodePort

selector:

app: myapp

release: stabel

ports:

- name: http

port: 80

targetPort: 80[root@k8s-master ceshi]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 6d6h

tsgj-svc NodePort 10.109.255.35 <none> 8080:30000/TCP 2d11h

[root@k8s-master ceshi]# kubectl get pod

NAME READY STATUS RESTARTS AGE

tsgj-deployment-855476f755-5l4qk 1/1 Running 0 34h

tsgj-deployment-855476f755-7rj8f 1/1 Running 0 34h

tsgj-deployment-855476f755-crkrn 1/1 Running 0 34h

[root@k8s-master ceshi]# iptables-save |grep tsgj-svc

-A KUBE-NODEPORTS -p tcp -m comment --comment "default/tsgj-svc:" -m tcp --dport 30000 -j KUBE-MARK-MASQ

-A KUBE-NODEPORTS -p tcp -m comment --comment "default/tsgj-svc:" -m tcp --dport 30000 -j KUBE-SVC-X5UEB5AP7D73JSAI

-A KUBE-SERVICES ! -s 10.244.0.0/16 -d 10.109.255.35/32 -p tcp -m comment --comment "default/tsgj-svc: cluster IP" -m tcp --dport 8080 -j KUBE-MARK-MASQ

-A KUBE-SERVICES -d 10.109.255.35/32 -p tcp -m comment --comment "default/tsgj-svc: cluster IP" -m tcp --dport 8080 -j KUBE-SVC-X5UEB5AP7D73JSAI

[root@k8s-master ceshi]# iptables-save|grep KUBE-SVC-X5UEB5AP7D73JSAI

:KUBE-SVC-X5UEB5AP7D73JSAI - [0:0]

-A KUBE-NODEPORTS -p tcp -m comment --comment "default/tsgj-svc:" -m tcp --dport 30000 -j KUBE-SVC-X5UEB5AP7D73JSAI

-A KUBE-SERVICES -d 10.109.255.35/32 -p tcp -m comment --comment "default/tsgj-svc: cluster IP" -m tcp --dport 8080 -j KUBE-SVC-X5UEB5AP7D73JSAI

-A KUBE-SVC-X5UEB5AP7D73JSAI -m statistic --mode random --probability 0.33332999982 -j KUBE-SEP-ACY2NRHQXCLYF447

-A KUBE-SVC-X5UEB5AP7D73JSAI -m statistic --mode random --probability 0.50000000000 -j KUBE-SEP-K7BRQOSBPSECSMB6

-A KUBE-SVC-X5UEB5AP7D73JSAI -j KUBE-SEP-UBOJ6DEUKSFU7YBC

[root@k8s-master ceshi]# iptables-save|grep KUBE-SEP-ACY2NRHQXCLYF447

:KUBE-SEP-ACY2NRHQXCLYF447 - [0:0]

-A KUBE-SEP-ACY2NRHQXCLYF447 -s 10.244.1.36/32 -j KUBE-MARK-MASQ

-A KUBE-SEP-ACY2NRHQXCLYF447 -p tcp -m tcp -j DNAT --to-destination 10.244.1.36:8080

-A KUBE-SVC-X5UEB5AP7D73JSAI -m statistic --mode random --probability 0.33332999982 -j KUBE-SEP-ACY2NRHQXCLYF447

[root@k8s-master ceshi]# iptables-save|grep KUBE-SEP-K7BRQOSBPSECSMB6

:KUBE-SEP-K7BRQOSBPSECSMB6 - [0:0]

-A KUBE-SEP-K7BRQOSBPSECSMB6 -s 10.244.1.37/32 -j KUBE-MARK-MASQ

-A KUBE-SEP-K7BRQOSBPSECSMB6 -p tcp -m tcp -j DNAT --to-destination 10.244.1.37:8080

-A KUBE-SVC-X5UEB5AP7D73JSAI -m statistic --mode random --probability 0.50000000000 -j KUBE-SEP-K7BRQOSBPSECSMB6

[root@k8s-master ceshi]# iptables-save|grep KUBE-SEP-UBOJ6DEUKSFU7YBC

:KUBE-SEP-UBOJ6DEUKSFU7YBC - [0:0]

-A KUBE-SEP-UBOJ6DEUKSFU7YBC -s 10.244.3.24/32 -j KUBE-MARK-MASQ

-A KUBE-SEP-UBOJ6DEUKSFU7YBC -p tcp -m tcp -j DNAT --to-destination 10.244.3.24:8080

-A KUBE-SVC-X5UEB5AP7D73JSAI -j KUBE-SEP-UBOJ6DEUKSFU7YBC

查询流程

iptables -t nat

LoadBalancer

loadBalancer 和 nodePort 其实是同一种方式。区别在于loadBalancer 比 nodePort多了以步,就是可以调用cloud provider 去创建LB来向节点导流

ExternalName

这种类型的 Service 通过返回 CNAME 和它的值,可以将服务映射到 externalName 字段的内容(例如:harbor.bwingame8.com)。ExternalName Service 是 Service 的特例,它没有selector,也没有定义任何的端口和 Endpoint。相反的,对于运行在集群外部的服务,它通过返回该外部服务的别名这种方式来提供服务。

kind: Service

apiVersion: v1

metadata:

name: my-service-1

namespace: default

spec:

type: ExternalName

externalName: my.database.example.com当查询主机 my-service.defalut.svc.cluster.local(SVC_NAME.NAMESPACE.svc.cluster.local)时,集群的DNS服务将返回一个值my.database.example.com的CNAME 记录。访问这个服务的工作方式和其它的相同,唯一不同的是重定向发生在DNS层,而且不会进行代理或转发